Amazon・Google・LINE。3大スマートスピーカー向けスキル対応って、ざっくり何が違うの?教えて!「謎のエンジニア」さん。

「2017年度見込比9.2倍の165億円」が見込まれるなど、今後の発展が期待されているスマートスピーカー(※1)。対話型の音声操作に対応したAIアシスタント(音声アシスタント)を利用するため、AIスピーカーと呼ばれることもあります。

現在、日本ではAmazon、Google、LINEの3社から発売されているスマートスピーカーが主力ですが、たとえば、Amazon Alexaでは1,000種を超えるスキルが公開されており(※2)、実用的なものから、クスッと笑ってしまいそうなものまで、内容はさまざま。アイデアや自社サービスを、「スマートスピーカー対応スキルとして、公開してみたい!」というエンジニア・マーケターも、多くいらっしゃるかも知れません。

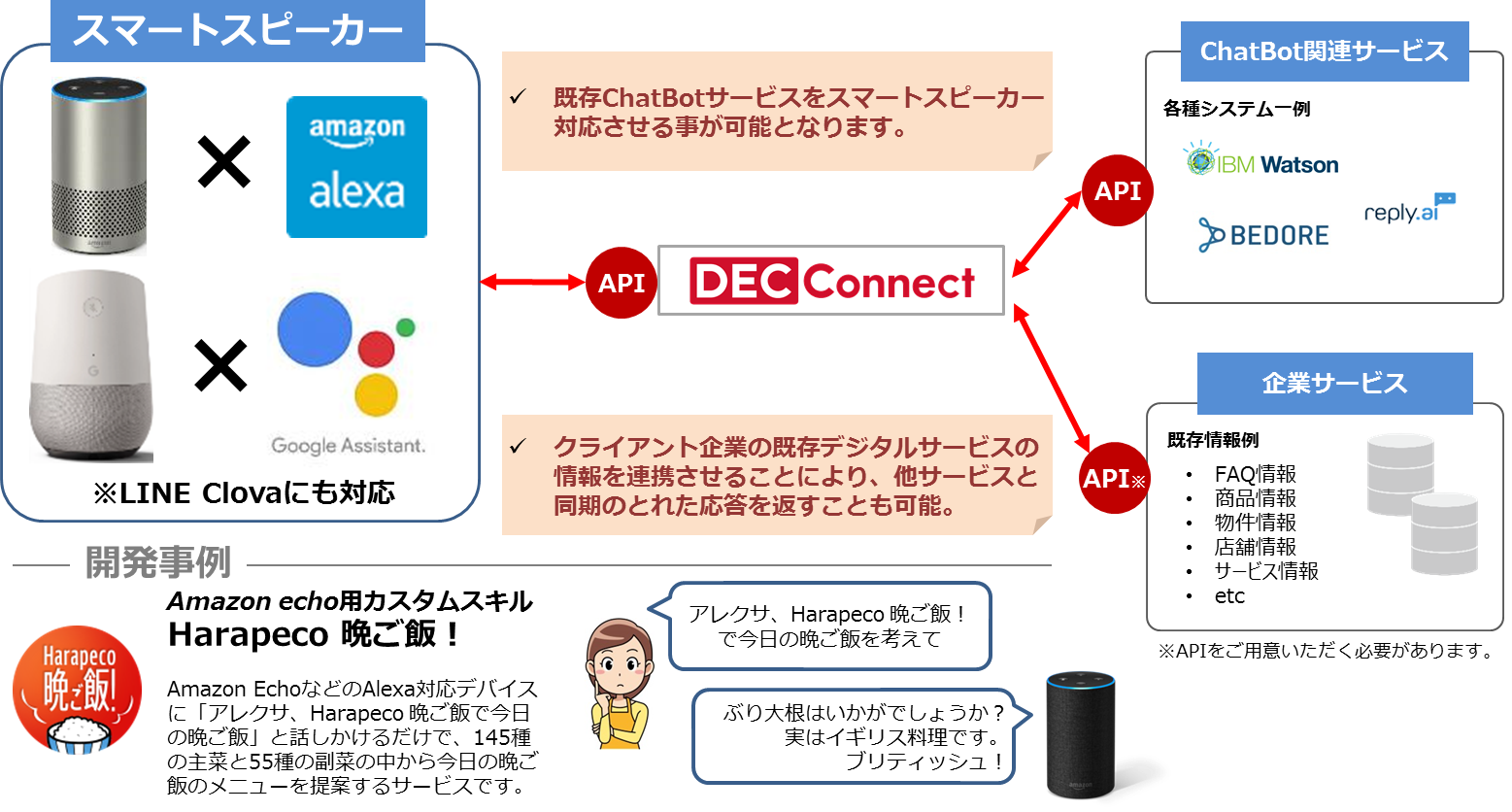

トランスコスモスでは、「Harapeco 晩ご飯!」という、献立のアイデアを提供する独自スキルを公開しており、Amazon、Google、LINEの3社すべての音声アシスタントに対応済み。

3大スマートスピーカー向けのスキル対応時に、大まかにどんな違いがあるのか?ノンエンジニアに公開はムリなのか?開発を担当した、今回の主役「謎のエンジニア」さんに聞いてきました。

「謎のエンジニア」 PHPをメインとしたオープン系エンジニア。数々のWeb・オープン系開発案件に携わった後、2007年頃よりトランスコスモス所属に。現在は、トランスコスモス独自スキル「Harapeco 晩ご飯!」のAmazon Alexa、Google Home、LINE Clova連携プロジェクトなど、新規サービス・ソリューションの開発を主に担当。色々と謎が深め。 |

※記載内容はすべて、取材日時点での情報です。予めご了承ください。

※2025年2月21日更新

目次[非表示]

Amazon・Google・LINEの3大スマートスピーカーに、スキルを対応済み

――トランスコスモスでの「スマートスピーカーへの対応状況」について、教えてください。

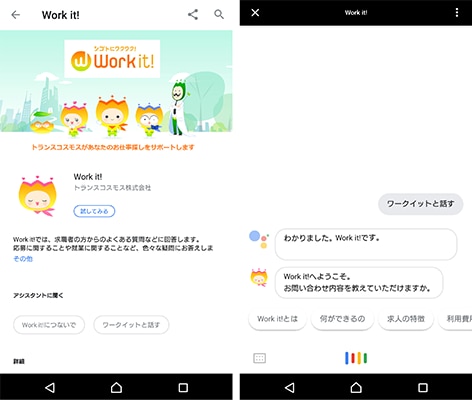

2017年末までにGoogle HomeとAmazon Alexa、2018年8月までにLINE Clovaに、トランスコスモスの中継モジュール「trans-Re:Connect(旧 DEC Connect)」を連携させています。trans-Re:Connectと繋ぎ、Amazon AlexaとLINE Clovaでは現在、トランスコスモス独自の「Harapeco 晩ご飯!」というスキルを公開中です。また、お仕事情報サイト「Work it!(ワークイット)」というサービスは、Googleアシスタントに対応しています。「OK Google、ワークイットと話す」と呼びかけるだけで、手軽に全国の仕事を探したり、質問や相談をしたりできます。

「Work it!(ワークイット)」でのGoogleアシスタント活用イメージ

――「Harapeco 晩ご飯!」について、簡単にご紹介いただけますか。

ひと言で申しますと、ハンズフリーで、晩ご飯メニューのアイデアをもらうことができるスキルです。「アレクサ、ハラペコ晩ご飯で、今日の晩ご飯」のように話しかけると、200種類以上のメニューから、おすすめの献立をダジャレまじりに回答してくれます。和・洋・中に、韓国料理も入っていてオトクです。

さらに、「アレクサ、ハラペコ晩ご飯で、もう一品」と話しかけていただくと、副菜やスープのメニューが追加で返答されます。また、「買い物や支度の手間を考えると、夕方にメニューを言われても困る」という声が社内からあがったので、夕方5時を過ぎたら、今日は外食にしましょうと提案するルールも設けています。

「trans-Re:Connect」活用し、 各AIエージェント、IBM Watsonを利用した「Harapeco 晩ご飯!」

――…あの、「Harapeco 晩ご飯!」ですが。 「いなり寿司は、いかがでしょうか?もう、あなたの言いなり」とか言われたんですけど?

メニューの返答については、耳で聞いたときにも、ダジャレとして成立するかの検証がなされています。そのため一時期は、業務のひとつとして、ダジャレを考えていたメンバーもおりました。なお、そちらの回答は、ワタクシが考えたわけではありません。

――へぇ、そうですか(疑)。…では、本題に。

ハイ。

「謎のエンジニア」さんですが、「糖質補給は常にしている感じ」らしいです

プログラミングができなくても、スキル公開はできる!?

――各社の違いの前に、スマートスピーカーで回答が返ってくる際の、そもそもの仕組みを確認させてください!

Amazonの例で説明しますが、ユーザの発話に応答するスキルには、いくつか種類があります。

|

カスタムスキルが、最も汎用的です。ユーザの発話内容に応じて自由な処理を行い、任意の応答を返すことができます。他のスキルは、用途特化型ですね。カスタムスキルが実行される流れは、以下のようになります。

※AWS Lambda:サーバ管理などをしなくてもコードを実行できるAmazonが提供するサービス |

―流れが複雑にも思えますが、どんな風に設定していくのですか?

Amazonは「Alexa Skills Kit」、Googleは「Dialogflow」、LINEは「Clova Extensions Kit」という、対話モデルを設定する管理画面をそれぞれ用意しています。裏側のサーバと、スマートスピーカーとの間に立って、自然言語の解析の簡素化をサポートしてくれますので、これらの各管理画面を活用するのが一般的です。

――管理画面…?もしかして、プログラミングができなくても、スキル公開できたりします…?

…イエ、それは、出来たほうが…。

――残念…。まぁ、そうですよね…。

とはいえ、「Dialogflow」の場合は、プログラミングなしで設定が可能です。トランスコスモスの「Work it!(ワークイット)」も、そのパターンで構築されているハズです。

――「Dialogflow」なら、プログラミングなしで設定が可能!…エンジニアでなくても、スキル公開できますか?

まぁ…、一応は、イエスです。

ただ、それでは提供できるスキル内容が限られてしまいます。関連するデータベースやAPIなどと連携するなど、'プログラミングあり'の方が、より面白いスキルを提供できるのではないでしょうか。また、「Alexa Skills Kit」と「Clova Extensions Kit」の場合は、ユーザへ応答文を返す環境が別途に必要ですので、そこではプログラミングが必要になりますし、先ほど挙げた「AWS Lambda」を活用するには、JavaScript等が書けなければいけません。スキル作成は、内容によっては、比較的簡単ではありますが、「エンジニアの言う'簡単'は、信用しないことにしている」という方もいますので、ご判断はお任せいたします…。

~ 参考:各社スマートスピーカー機器とアシスタント ~

【Amazon】 ・Amazon Echo ・Alexa ・skill 「Alexa」などの呼びかけ音声をトリガーに、AIアシスタントが起動。後に続く音声情報から、「Slot(何を)」・「Intent(してほしい)」を抽出し、あらかじめ設定されているアクションが反応します |

【Google】 ・Google Home ・Actions on Google ・Action 「OK Google」などの呼びかけ音声をトリガーに、AIアシスタントが起動。後に続く音声情報から、「Entity(何を)」・「Intent(してほしい)」を抽出し、あらかじめ設定されているアクションが反応します |

【LINE】 ・Clova Wave ・Clova ・スキル 「Clova」などの呼びかけ音声をトリガーに、AIアシスタントが起動。後に続く音声情報から、「Slot(何を)」・「Intent(してほしい)」を抽出し、あらかじめ設定されているアクションが反応します |

それぞれの'音声認識AIエージェント'へ、個別対応は必須

――やっぱり、各社の提供環境って、それぞれ違いますか?

ハイ。そもそもの対話モデル(ユーザ発言がどのようなリクエストに該当するかのルールを定義したもの)の概念が違いますので。それぞれ管理画面も別々ですしね…。

ただ、似ている部分もあります。三者三様とはいえ、AlexaとClovaは、「Slot(何を)」・「Intent(してほしい)」が、共通していますよね?設定方法も、似ています。

個人的な感覚としては、まだスキル開発キットが一般公開されたばかりのClovaは、Alexaをかなりシンプルにしたモデル、という印象です。大きな違いとしては、Clovaには、「Slot filling」という機能がありません。

――「Slot filling」…? スロット='何を'を埋めるための機能ですか…?

ハイ。

たとえば、スマートスピーカーを使って、ピザを注文しようとした場合に――

――ピザ?

ハイ。ピザです。ピッツア。

ピザの注文を受けようと思ったら、少なくとも'種類'と'数'を指定してもらう必要がありますよね。ユーザから、両方の回答をもらうことは、お店側からすると必須です。しかし、ユーザがお店側の期待通りに回答してくれるとは限りません。種類だけを回答されたり、あるいは関係ない話をされたりと、いろいろな回答ケースが想定されます。

「Alexa Skills Kit」や「Dialogflow」に準備されている「Slot filling」という機能が活躍するのは、このような場面です。「'種類'しか回答していないユーザには、次に'数'を問い返す」などと予め設定しておいて、必須項目をすべてユーザに回答してもらう。そのうえで、裏側のサーバへデータを渡す、ということが可能です。

一方、「Clova Extensions Kit」にはこの機能がありません。必須の情報が含まれていなくても、ユーザの回答を受け止める仕様になっています。必要な回答を集めるためには、「Clova Extensions Kit」内ではなく、サーバ側で、追加質問を投げかける仕組みを予め準備しておく必要があります。

「謎のエンジニア」さん、慕われている模様です

――ちなみに、「どれが好き」とかあります?

強いて言えば、自由度の高さでGoogleでしょうか。他にはない、「context」という概念があります。

――「context」…? コンテキスト=文脈…??

ハイ。一問一答形式のやり取りであれば3つとも大きな差はないのですが、いわゆる'シナリオ型'のやり取りをする場合に、「context」の概念があると便利です。管理画面から、複数のインテントを組み合わせた設定が可能になります。

このとき、仮にユーザが「伊豆に行こうと思ってはいるが、どうやって行くかはまだ迷っている」状態であれば、その後に続けて、「電車だと、どれくらい?」と訊くケースはあり得ますよね。

こうした場合に、コンテキストの設定がされていると、「東京・伊豆間」というエリア情報を保持したまま、2つめの質問に対応することが可能になります。つまり、「電車だと、どれくらい?」とだけ発話されても、「東京から伊豆まで、電車でどれくらいかかるのか?」という質問である、と明確化して回答を返すことができる。どちらを先に訊いたかなどの順序も気にしなくて構いません。ユーザの利便性を、より高めることができます。

スキル公開だけなら、'無料'でも可能!

――コストはいかがでしょう?結構かかるものですか?

イエ。スキルを各スマートスピーカーに対応させること自体は、安く実現することが可能です。というか、無料でも可能です。まず、先にご紹介した「Dialogflow」など、スキルを開発・拡張できる管理画面は一般公開されており、無料で利用することができます。また、サーバに関しても、Alexaは「AWS Lambda」、Googleは「Cloud Functions(※GCP上でJavaScriptで書かれた関数を実行するためのサービス)」というサービスの提供があり、それらを活用すれば、裏側に自分でサーバを用意する必要がありません。この2つのサービスは、いずれも合計処理時間による制限はありますが。

Amazon Alexaの公開前スキル審査は、3回リジェクトされた

――スキル公開前の審査は、どうでした?

「Harapeco 晩ご飯!」のAlexaスキル公開審査を担当しましたが、計3回リジェクトされています。2017年12月のことです。

――3回も!Alexaスキル認定って、厳しいのでしょうか?

イエ。厳しいというよりは、各回で別の視点の審査が行われていた印象でした。

初回は、提供したい対話モデルの概要や設定内容についての確認。2回目は、挙動の確認。最後は、セキュリティ面の確認だったと記憶しています。

――審査が長期化して、ローンチが遅れたりしませんでした?

イエ。そのようなことはなかったです。

あくまで当時の話ですが、スキル申請時の受付メールには、「5営業日以内に、フィードバックが届くか、公開がされる」と記載されていたものの、基本的に翌営業日にはフィードバックが届きました。12月18日に初回の申請をして、27日に公開に至りましたので、迅速にご対応いただけたと思います。

――スキル公開、意外とハードル低そうですね!

ハイ。

――今後ですが、AIやスマートスピーカーの活用に注力していくのでしょうか?

イエ、それだけに着目して開発する、ということはないかと思います。

企業にとっては、スマートスピーカーは伸びしろがある'ユーザとのコミュニケーションツール'であると思いますし、開発をしないというわけではありません。ただ、あくまでも、1つのデバイスです。実現したいサービスの世界観に、スマートスピーカーがマッチすれば、実装するだけです。

現状トランスコスモスとしては、工数削減と将来の拡張性を担保するために、企業様のサービスや一般に開放されているシステムのAPIと、トランスコスモスの独自中継ハブ「trans-Re:Connect」を連携させるサービスを提供しています。自由度が高めのサービスですので、スマートスピーカーに限らず「こんなことがしたい」というご希望があれば、可能な限り対応させていただく感じでしょうか。

――「スマートスピーカーは、あくまで1つのデバイス」ということですが…、この先への期待感、お持ちですか?

ハイ。加えて、スマートスピーカー以外の新たなデバイスが出てきたり、それによって、もっとラクなコミュニケーションができるようになったり、という可能性はあると思います。

メールなどテキストのコミュニケーションに適したデバイスがあって、音声に対応したスマートスピーカーがあって。まばたきや視線の動きだけで操作ができるウェアラブル端末なども出てきています。

将来は、たとえばですが、'頭に思い描いただけで、相手に考えを伝える'ことも可能になるかも知れません。脳の特定のシナプスの情報伝達だけを汲み取って、テキストや音声に表現してくれるような仕組みで。そうしたら、健康状態や言語能力に関わらず、誰とでも意思疎通がはかれる世界に、なるかも知れないですね。

<参考>

株式会社ジャストシステム:自主調査レポート

https://marketing-rc.com/report/report-ai2017-20180308.html